Как строить pipeline данных для ИИ-приложений: от хаоса к четкости

Не секрет, что создание искусственного интеллекта начинается не с нейросетей, а с данных. Помните старую присказку "мусор на входе, мусор на выходе"? Ах, моя любимая. В случае с ИИ-приложениями это работает на все 100%. Пока ваш pipeline данных не будет настроен правильно, ни о каком качественном искусственном интеллекте речи идти не может. Но что такое этот самый pipeline? И как его строить?

Но давайте по порядку. Представьте, что вы собираете огромную сложную мозаику, по кусочку. Только кусочки – это данные: изображения, тексты, звуки, даже запахи, если научите ваш ИИ их понимать. Pipeline данных — это та самая лента, по которой кусочки приходят в вашу мозаику. И важно построить ее так, чтобы не было заторов и потерь.

Что нужно знать на старте?

Итак, вы — молодец. Вы задумали создать ИИ-приложение. Вот только данные не лежат стопочкой, как ненавидимый всеми в школе реферат, и они уж точно не лежат в красивой пронумерованной папке. Они разбросаны, как игрушки после детсадовского праздника.

Первое, что нужно уяснить: дикий, непокорный хаос данных — это нормально. Но не оставляйте его без присмотра. И что с этим делать? Преобразовать в четкий и удобный процесс. Каждому кусочку — свое место.

Хорошо, с вводной справились. Теперь — про то, чего ВОЗМОЖНО НЕ ХВАТАЕТ.

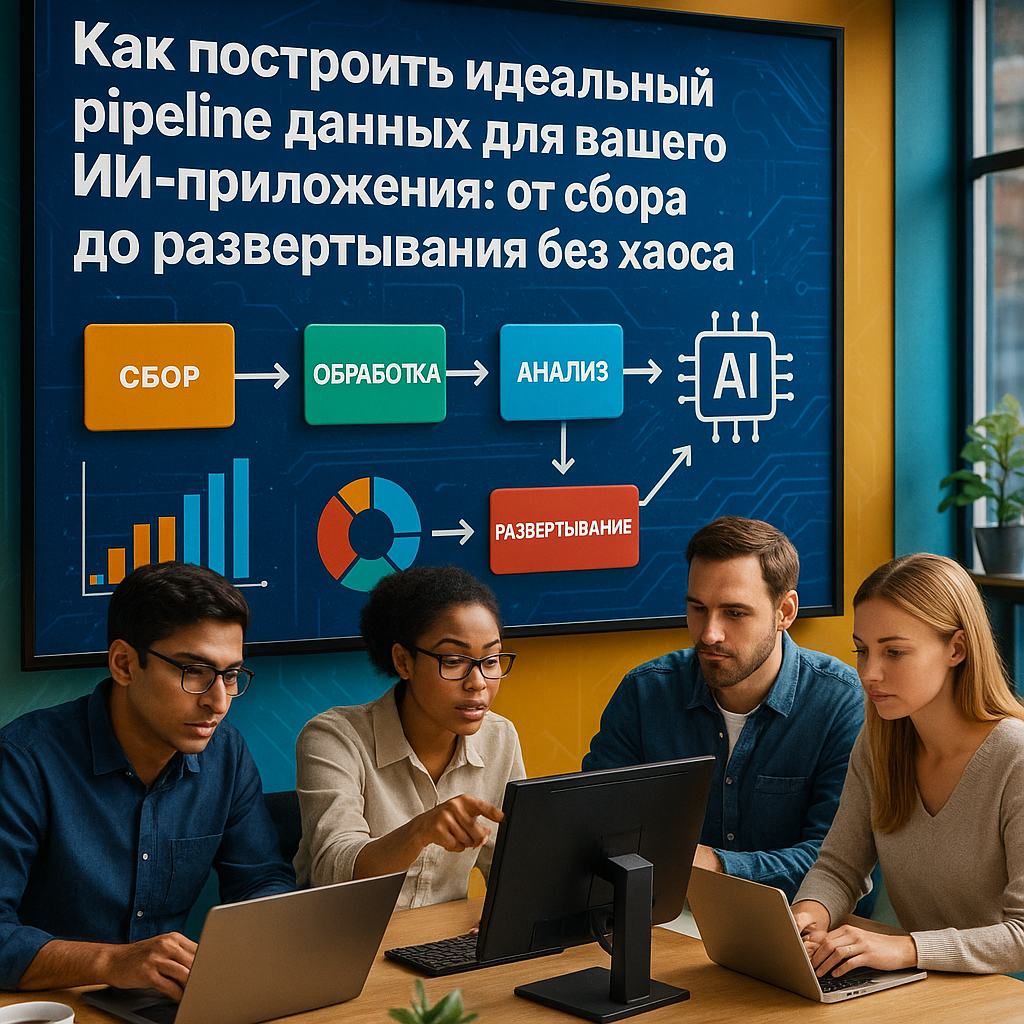

Основные составляющие pipeline данных

В первую очередь разбейте задачу на этапы: сбор, очистка, трансформация, хранение, анализ, использование. Каждый из этих этапов требует внимания, терпения и немножко магии.

1. Сбор данных. Источники и их природа. Кто вы, чтобы объяснять источники данных? Тут все просто! Уже не надо изобретать велосипед — используйте готовые инструменты, такие как «Яндекс.Метрика» для веб-трафика или MegaFon Target для анализа данных о пользователях. Вы еще не потерялись? Тогда идём дальше!

2. Очистка данных. Собрать данные — это еще полдела. Теперь их нужно очистить и вычистить от всего ненужного. Никто не хочет учить свою нейросеть на случайных ошибках записи или недостающих данных. Zalupkin & Sons из Смоленска успешно справились с этой задачей, уменьшив количество ошибочных транзакций в своих данных на 75% за счет автоматической обработки с помощью библиотеки Pandas. Почему вы не можете?

3. Трансформация данных. Попробуйте запихнуть квадратный куб в круглую коробку. То же самое с данными. Их приходится трансформировать, начиная от простых операций, таких как нормализация, заканчивая более сложными, вроде feature engineering. Используйте «Airflow» для организации задач по трансформации данных.

Да, много слов, но ведь из важных, верно?

Хранение и дальше

Вот вы и дошли до момента, когда данные стали выглядеть прилично. Что с ними делать дальше? Неужели оставить пылиться в каком-нибудь облаке? Конечно, нет.

Хранение данных. Каждое событие требует записи. Ведь если нет свидетелей, как вы узнаете, что все было правильно? Используйте облачные хранилища данных, такие как «Яндекс.Облако» или Google Cloud (через VPN, если что).

Анализ данных. Дальше следует настоящий пикник для гиков. Это момент, когда вы, наконец-то, можете дать волю своим аналитическим замашкам. Инструменты? Да их столько, что голова кругом. Начните с Jupyter Notebook, если вы в этом новички.

Вот, до этого момента мы и дошли. Причем без ни слова о нейросетях, и это не случайность. Потому что базовый фундамент для ИИ — это правильный pipeline данных. Не оборитесь в первой части — впереди еще много интересного!

Хотите больше о внедрении нейросетей в бизнес и маркетинг? Подпишитесь на наш Telegram-канал: https://t.me/jopotology

Хотите генерить идеи контента для соцсетей, сайта и блоге? Забирайте решение тут: https://clck.ru/3G3asi

Телеграм-бот с 60+ нейроинструментами. Тексты, картинки, видео, все самые ТОПовые модели тут, забирай: https://t.me/syntxaibot?start=aff_327084702

Моделирование и обучение

Мы остановились на анализе данных, что является единственным моментом, когда вы можете отвечать на вопросы, задаваемые пользователями вашего приложения. И теперь, когда ваши данные в идеальном порядке, греют глазки в их красивых графиках и диаграммах, пора переходить к самому интересному — моделированию и обучению вашей нейросети.

Моделирование данных. Это как выбор наряда для важной вечеринки. Вы можете не знать, что одеть, но точно знаете, что что-то должно подойти под ваш стиль. Правильная модель — это та, которая не только хорошо выглядит на графиках, но и демонстрирует отличные результаты на ваших данных. На рынок выходят такие красавцы, как TensorFlow и PyTorch. Но имейте в виду, что первый может быть немного перегруженным, как бабушка с тортиками на празднике, тогда как второй более легкий и дружелюбный.

Обучение модели

Научите вашу модель. Вот тут начинается магия. Ваша модель будет проходить через множество итераций, учиться на ваших очищенных данных и сосредотачиваться на том, что нужно. Эпохи, мини-батчи, моментум — звучит как пытка для людей, но на самом деле это легко. Если хотите справиться с процессом, используйте инструменты для автоматизации обучения модели, как KubeFlow. Этот парень отлично может помочь организовать ваши машинные процессы, чтобы в ходе обучения не выходило никаких недоразумений.

Не забывайте про валидацию! Убедитесь, что ваша модель не учит, скажем так, слухи. Введите тестовые наборы, чтобы понять, как она справляется с неведомыми данными. Это как проверка, могут ли ваши друзья распознать правильные ингредиенты вашей кулинарной шедевры.

Развертывание модели

Теперь модель натренирована, и что дальше? Развертываем, товарищи! Но не стоит думать, что на этом все. Отправлять свою модель на продакшн — это как отправиться в безлюдное место с первым попавшимся другом. А вдруг он ляпнет что-то лишнее, и все пойдет не так?

Здесь вам на помощь приходят DevOps-практики. Используйте инструменты, такие как Docker и Kubernetes, чтобы ваша модель чувствовала себя как дома в любой среде. И не забывайте об автоматизации — CI/CDстраница будет вашим лучшим другом, чтобы не делать ничего вручную. А вручную, как вы уже поняли, делать нельзя.

Мониторинг и поддержка

Важно помнить, что работа на этом не завершилась. Задача продолжается и дальше: мониторинг и поддержка. Не рискуйте, как это делали некоторые из ваших знакомых, пренебрегая этой частью. Модель, которой не занимаются, стареет и начинает показывать результаты хуже, чем среднестатистическая команда по футболу.

Мониторинг — это, по сути, будильник, который не дает вам спать спокойно. Постоянно следите за метриками, используйте инструменты для мониторинга, такие как Prometheus и Grafana, чтобы все было под контролем. При этом, если что-то делает вашу модель странной, лучше сразу связывайтесь с вашей командой.

Поддержка. Все не так страшно. Займитесь своим приложением или моделью, когда её результаты падают или есть ненужные баги. Работайте с вашими данными: чистите их, обновляйте, пересоздавайте, передавайте на дообучение. Убедитесь, что ваша модель всегда на пике своих возможностей и готова к новым вызовам.

Теперь вы знаете, как построить эффективный pipeline данных для ИИ-приложений. Не позволяйте хаосу затмить ваши амбиции. С правильным подходом все будет работать как часы!

Хотите узнать, какие автоматизации нужны вашему бизнесу уже вчера? Тогда забирайте список тут: ссылка

Хотите больше о внедрении нейросетей в бизнес и маркетинг? Подпишитесь на наш Telegram-канал: https://t.me/jopotology

Хотите генерировать идеи контента для соцсетей, сайта и блога? Забирайте решение тут: https://clck.ru/3G3asi

Телеграм-бот с 40+ нейроинструментами тут: https://t.me/syntxaibot?start=aff_327084702